本地翻译,其实小的LLM模型就可以,而且很快:Qwen 3 (1.7B)

本地翻译操作指南

本指南旨在帮助您在本地环境中使用 Ollama 部署 Qwen 3 (1.7B) 模型,并通过 Cherry Studio 实现快速翻译。

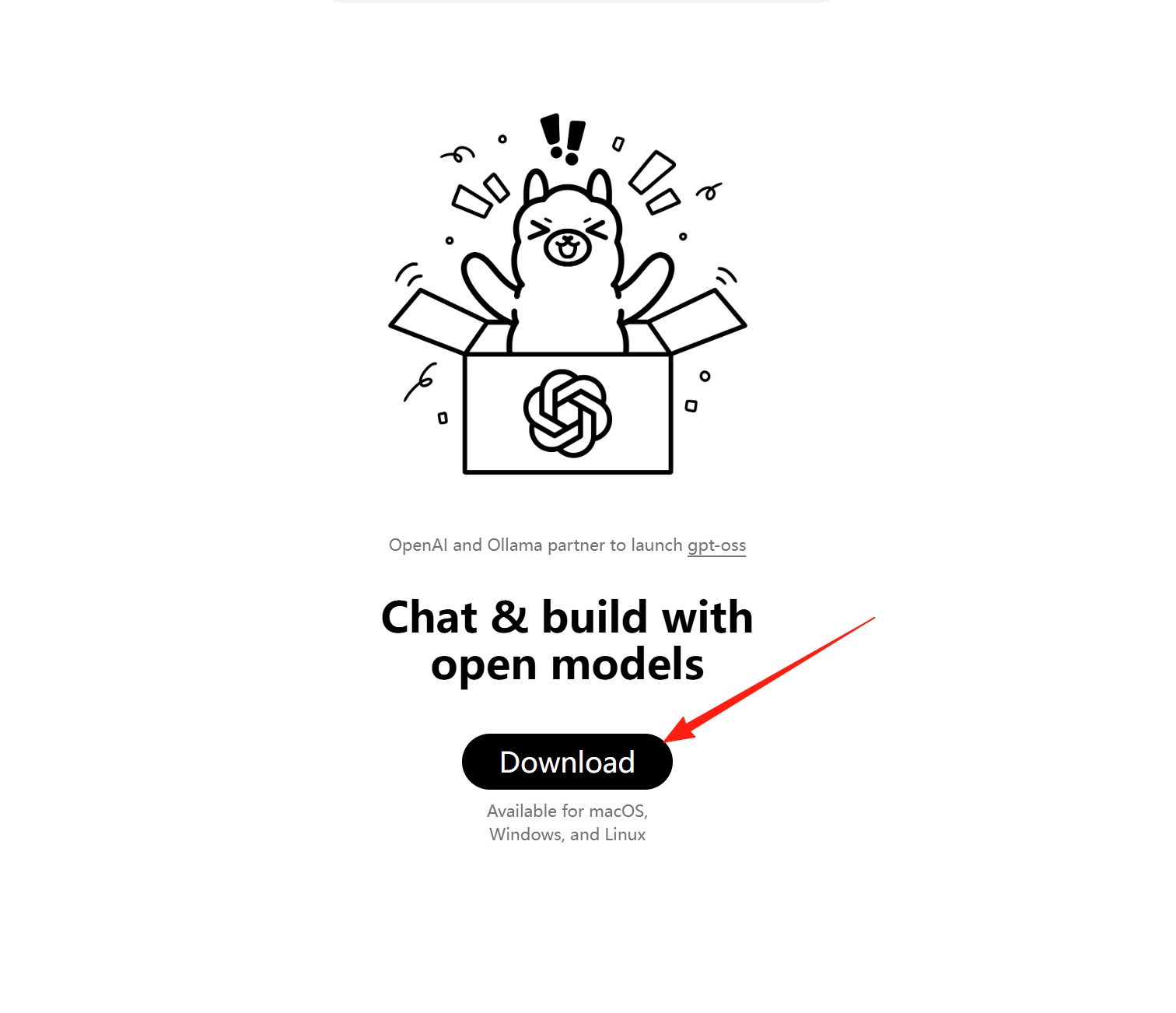

1. 下载和安装 Ollama:

- 访问 Ollama 官方网站:

https://ollama.com/。 - 根据您的操作系统(Windows, macOS, Linux),下载并安装 Ollama 客户端。

2. 下载 Qwen 3 (1.7B) 模型:

Ollama 提供了两种下载模型的方式:

- 通过 Ollama 桌面客户端界面:

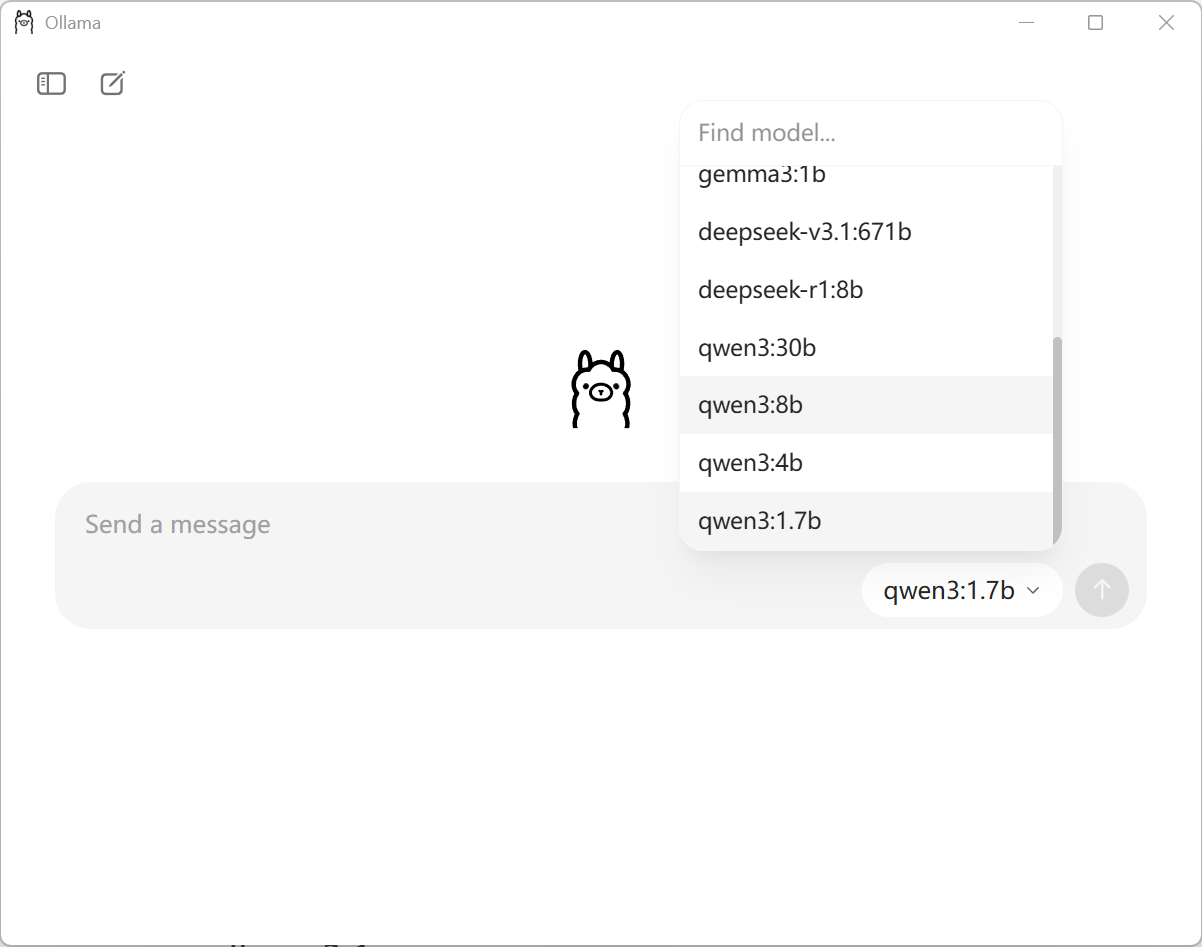

- 启动 Ollama 客户端。

- 在界面右下角找到当前选择模型的下拉菜单,点击它。

- 在弹出的模型列表中,您可以通过滑动查找

qwen3:1.7b。如果未列出,可以在顶部的“Find model...”搜索框中输入qwen3:1.7b进行搜索。 - 点击

qwen3:1.7b,Ollama 会自动开始下载该模型(约 1.4GB)。

- 通过命令行(如果 Ollama 桌面客户端不支持此功能或您更喜欢命令行):

- 打开命令行工具(如 PowerShell 或 Terminal)。

- 执行命令:

ollama pull qwen3:1.7b。Ollama 将下载模型到您的本地。

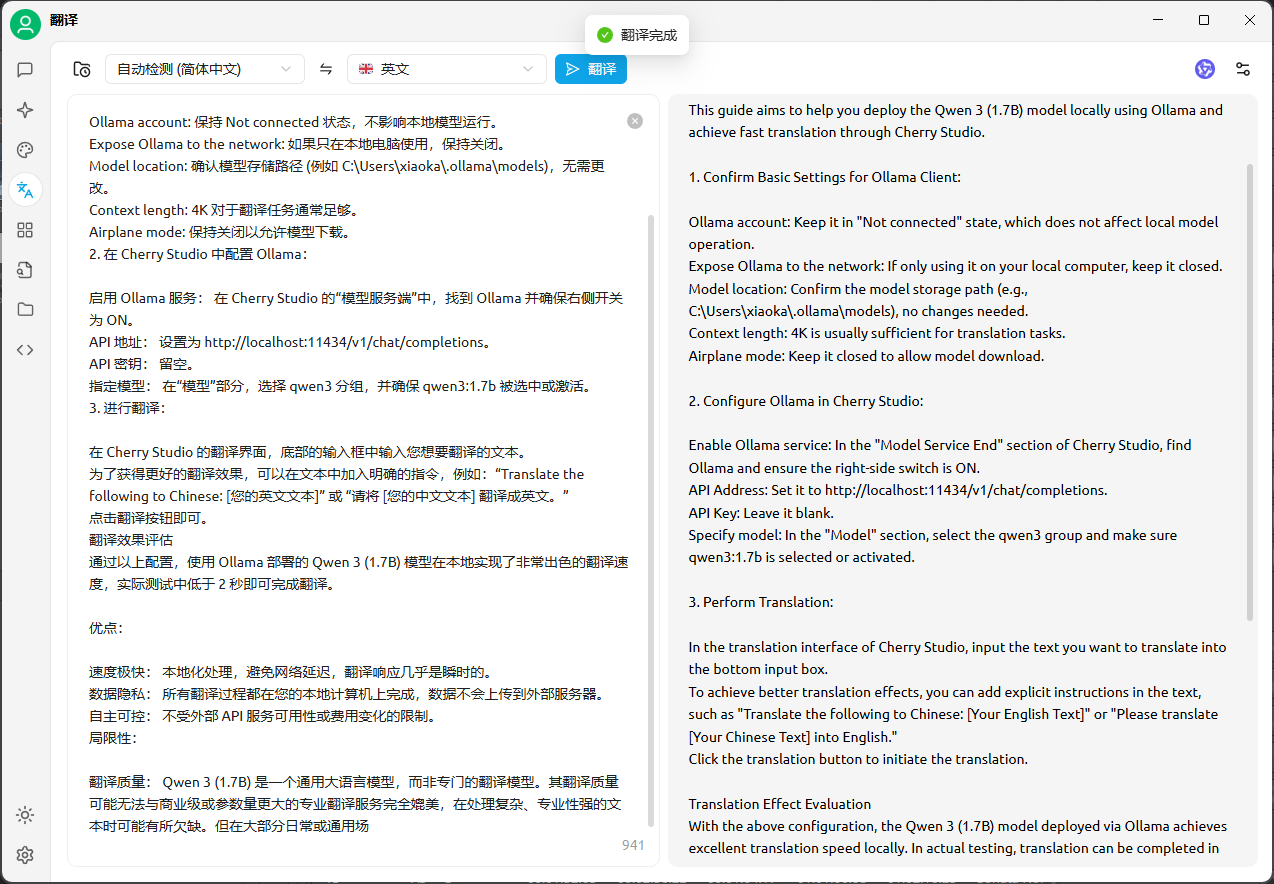

3. 确认 Ollama 客户端基础设置:

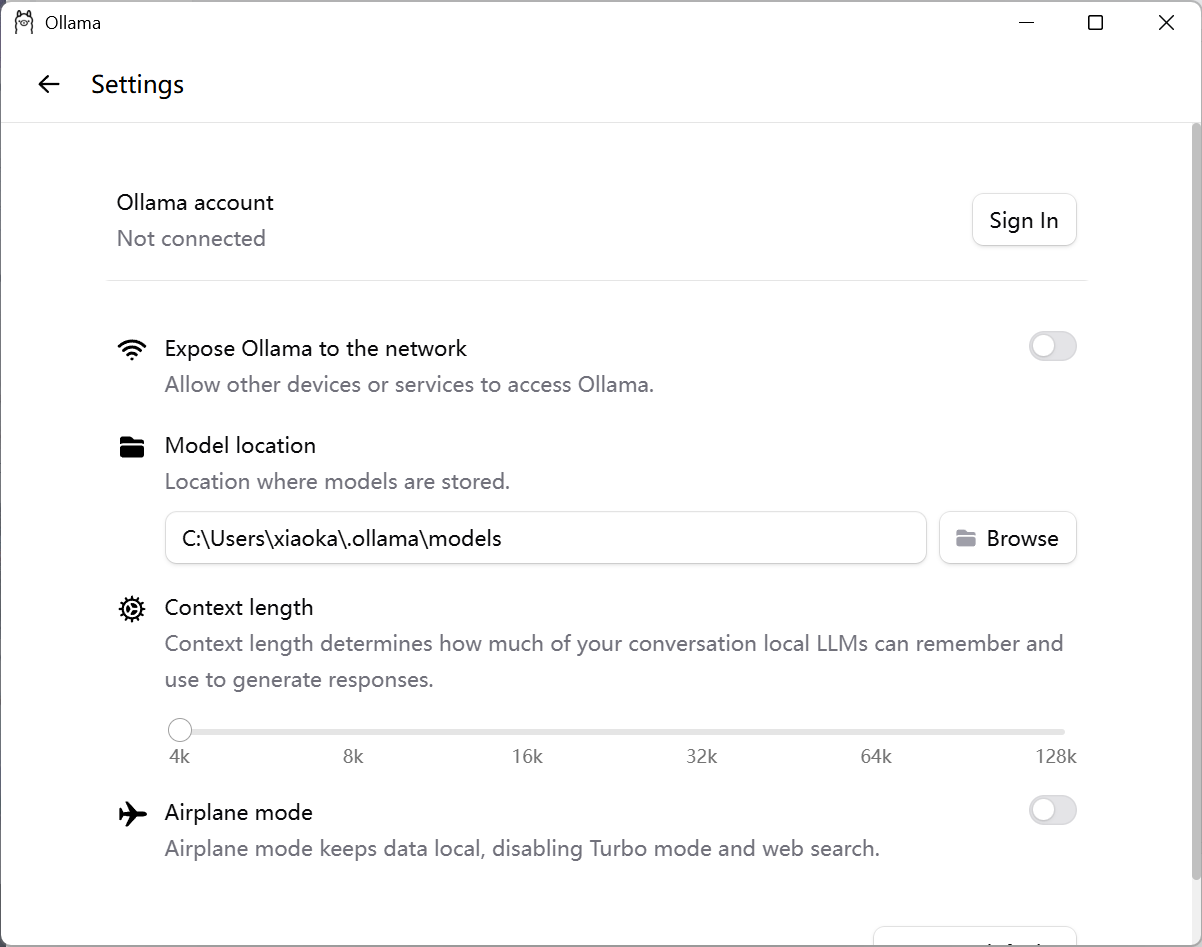

- Ollama account: 保持

Not connected状态,不影响本地模型运行。 - Expose Ollama to the network: 如果只在本地电脑使用,保持关闭。

- Model location: 确认模型存储路径 (例如

C:\Users\xiaoka\.ollama\models),无需更改。 - Context length: 4K 对于翻译任务通常足够。

- Airplane mode: 保持关闭以允许模型下载。

4. 在 Cherry Studio 中配置 Ollama:

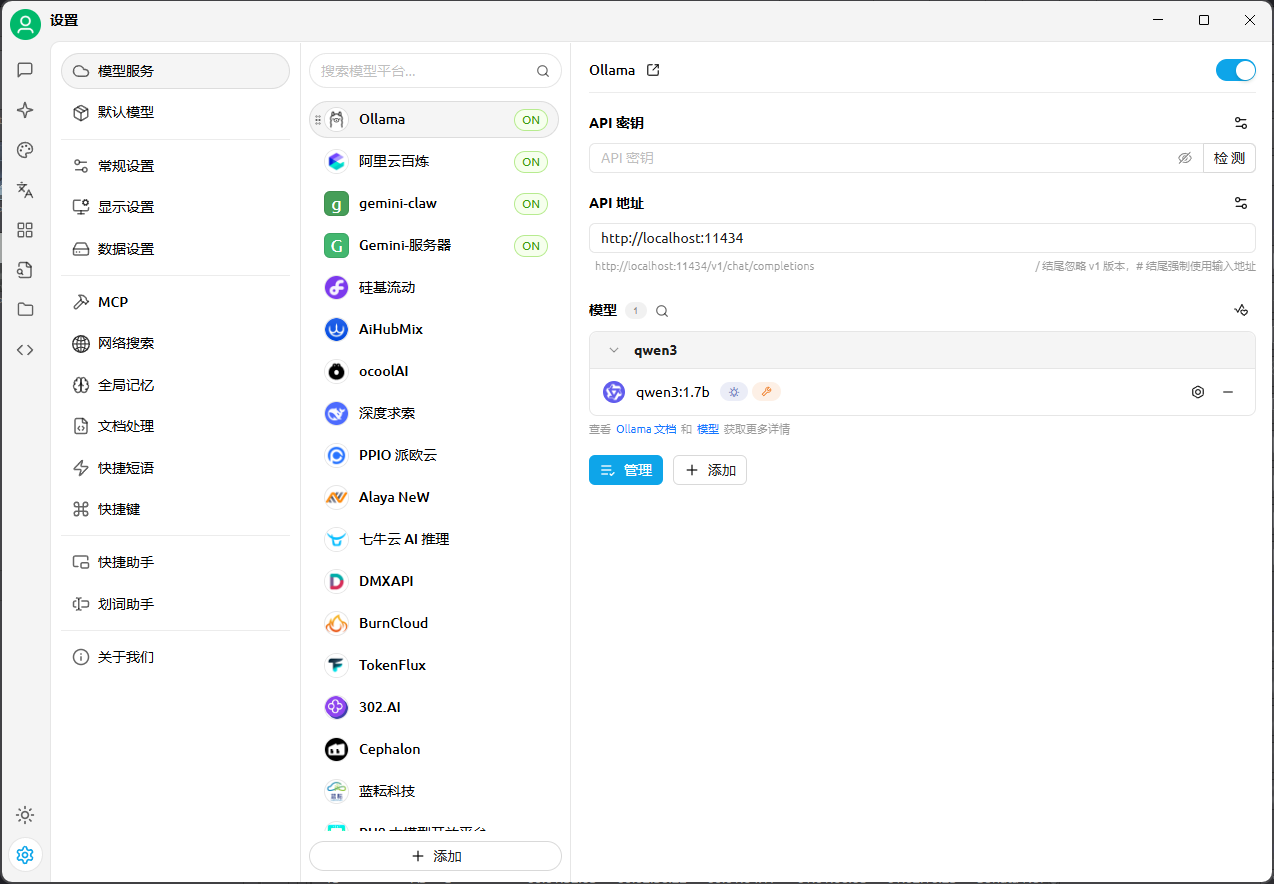

- 启用 Ollama 服务: 在 Cherry Studio 的“模型服务端”中,找到

Ollama并确保右侧开关为 ON。 - API 地址: 设置为

http://localhost:11434/v1/chat/completions。 - API 密钥: 留空。

- 指定模型: 在“模型”部分,选择

qwen3分组,并确保qwen3:1.7b被选中或激活。

5. 进行翻译:

- 在 Cherry Studio 的翻译界面,底部的输入框中输入您想要翻译的文本。

- 为了获得更好的翻译效果,可以在文本中加入明确的指令,例如:“Translate the following to Chinese: [您的英文文本]” 或 “请将 [您的中文文本] 翻译成英文。”

- 点击翻译按钮即可。

翻译效果评估

通过以上配置,使用 Ollama 部署的 Qwen 3 (1.7B) 模型在本地实现了非常出色的翻译速度,实际测试中低于 2 秒即可完成翻译。

优点:

- 速度极快: 本地化处理,避免网络延迟,翻译响应几乎是瞬时的。

- 数据隐私: 所有翻译过程都在您的本地计算机上完成,数据不会上传到外部服务器。

- 自主可控: 不受外部 API 服务可用性或费用变化的限制。

局限性:

- 翻译质量: Qwen 3 (1.7B) 是一个通用大语言模型,而非专门的翻译模型。其翻译质量可能无法与商业级或参数量更高的比,但已经足够。

本文是原创文章,完整转载请注明来自 森魔王

评论

匿名评论

隐私政策

你无需删除空行,直接评论以获取最佳展示效果